Technisches SEO

Passende Domain verwenden

Domain

Um es gleich vorwegzunehmen: Die Domain hat bzgl. SEO keinen entscheidenden Einfluss.

Dennoch sollte man die Domain für den Benutzer und somit potentiellen Kunden sorgfältig auswählen. Sie sollte in Verbindung zum Unternehmen stehen. Das kann beispielsweise durch die Verwendung des eigenen Markennamens geschehen, der eine Art Vertrautheit schafft, als auch durch eine thematische Relevanz zum Unternehmen. Beides ist auch kombinierbar!

Idealerweise sollte die Domain kurz und gut einprägbar sein. Eine kurze Domain schaut auf Visitenkarten oder anderem Druckmaterial zudem auch schöner aus.

Sogenannte Keyword-Domains,die bestimmte Keywords enthalten, spielen beim Ranking im Prinzip keine Rolle mehr. Die Suchmaschinen generieren sich die Keywords aus dem Inhalt der Webseite.

Domain-Endung (TLD: Top Level Domain)

Es spielt hinsichtlich SEO fast keine Rolle, welche Domain-Endung man verwendet. Die klassischen TLDs (.com, .org, usw.) werden genauso behandelt wie die generischen TLDs (z.B. .club, .shop, usw.). Sollte die TLD ein Keyword enthalten, so ist das für die Suchmaschinen ebenso irrelevant.

Anders schaut es jedoch bei den länderspezifischen TLDs aus! Eine Domain-Endung wie z.B. ".de" wird in Deutschland höher bewertet als in Südafrika. Regionale Domains wie beispielsweise ".berlin" werden hingegen genauso bewertet wie .com-Domains.

SSL-Zertifikat einsetzen

Verwendet man ein SSL-Zertifikat für seine Webseite, dann werden die Daten zwischen der Webseite und dem Server verschlüsselt übertragen. Dadurch wird die Webseite sicherer, was wiederum Vertrauen bei den Besuchern der Webseite schafft.

Mittlerweile melden einige Browser, wenn eine Webseite unsicher ist. Dann ist die Gefahr groß, dass Webseitenbesucher die Webseite gleich wieder verlassen. Suchmaschinen wie Google und Co. stufen eine unsichere Webseite ab, was sich in einem schlechteren Ranking auswirkt. Ein SSL-Zertifikat ist also unbedingt empfehlenswert.

Es kommt noch hinzu, dass beispielsweise Daten in Kontaktformularen aus datenschutzrechtlichen Gründen nur verschlüsselt übertragen werden dürfen!

Eine abgesicherte Webseite hat den Vorsatz https (Hypertext Transfer Protocol Secure) in der URL stehen. Ist die Webseite unsicher, dann fehlt das "s" und der Vorsatz lautet nur http.

Es gibt unterschiedliche SSL-Zertifikate, z.B. für 1 Domain, für 1 Domain und ihre Subdomains, für Multi-Domains sowie Zertifikate mit verschiedenen Validations oder gedeckten Schadensummen, u.v.m.

Ein SSL-Zertifikat verwendet heutzutage das TLS-Protokoll (Transport Layer Security), welches der Nachfolger des SSL-Protokolls (Secure Socket Layer) ist.

Da die Abkürzung "SSL" entwicklungstechnisch bekannter ist als "TLS", wird von den Hostern weiterhin der Begriff "SSL" , teils auch "SSL/TLS" verwendet.

Die aktuelle TLS-Version ist 1.3. Die veralteten Protokolle SSL 2.0 und SSL 3.0 sind unsicher und dürfen nicht mehr verwendet werden! Auch TLS 1.0 und 1.1 werden nicht mehr unterstützt.

URL-Struktur optimieren

Als nächstes sollte man die URL-Struktur optimieren. Eine aussagekräftige URL vermittelt den Besuchern einer Webseite nämlich einen ersten Eindruck, was sie auf dieser Seite erwarten wird, z.B. die Kontaktdaten unter der URL "www.joominator.de/de/kontakt". Hier dürfen gerne auch Keywords eingesetzt werden. Allerdings sollte man es mit den Keywords nicht so übertreiben und die URLs so kurz wie möglich halten.

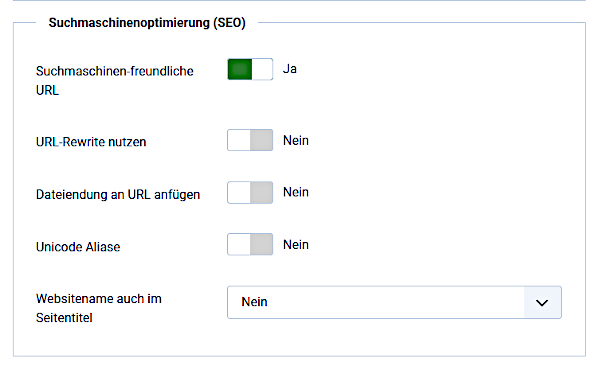

In Joomla kann man die URL-Struktur optimieren, indem man die "Suchmaschinen-freundlichen URL’s" aktiviert!. Hierbei bietet Joomla mehrere Varianten an.

Rufen Sie zunächst die folgende Seite im Backend von Joomla auf:

"System" -> Einstellungen: "Konfiguration" - TAB "Site"

oder alternativ über das Dashboard!

Ohne Suchmaschinen-freundliche URLs

Ohne jegliche Aktivierung ist weder für den Besucher der Webseite noch für eine Suchmaschine erkennbar, was sich hinter der URL verbirgt. In Joomla schaut diese z.B. folgendermaßen aus:

https://example.org.de/index.php?option=com_content&view=category&layout=blog&id=3&Itemid=102

Suchmaschinen-freundliche URLs

Im ersten Schritt zur Optimierung der URL stellt man nun die Option “Suchmaschinen-freundliche URLs” auf "Ja". Dadurch wird u.a. auch der Alias des Menüpunktes in der URL verwendet. Die URL ist nun bereits deutlich kürzer:

https://example.org/index.php/blog

URL-Rewrite

Im zweiten Schritt wird das "/index.php" in der URL entfernt. Dazu wird zusätzlich "URL-Rewrite nutzen" auf "Ja" gestellt!

Wichtig: Die Option "URL-Rewrite nutzen" funktioniert nur dann, wenn man auch gleichzeitig die in Joomla enthaltene htaccess.txt in .htaccess umbenennt! Dort stehen nämlich Anweisungen drin, mit denen die URLs intern und für den Besucher unsichtbar umgeschrieben werden.

Wird diese Umbenennung nicht vorgenommen, dann sind nach Aktivierung von "URL-Rewrite nutzen" die Unterseiten (Menüpunkte) nicht mehr erreichbar (404). Damit die Datei vom Webserver auch abgearbeitet werden kann, ist die korrekte Schreibweise wichtig: Ein Punkt vor dem Dateinamen und keine Dateiendung!

Die Umbenennung erfolgt über FTP oder ein Webinterface (z.B. Web-FTP) des Hosters. Im ersten Fall eignen sich dafür FTP-Programme wie z.B. FileZilla. Bitte immer die aktuelle Version verwenden! Da die .htaccess mit einem Punkt beginnt, kann es vorkommen, dass diese nach der Umbenennung nicht mehr sichtbar ist. Das lässt sich aber in der Regel im verwendeten Programm einstellen, indem man beispielsweise "Versteckte Dateien anzeigen" aktiviert!

Es kann sein, dass bereits eine .htaccess existiert. Dort können nämlich auch Anweisungen wie die zu verwendete PHP-Version, 301-Weiterleitungen, Cache-Anweisungen oder HTTP Security-Header reingeschrieben werden. In diesem Fall ist die .htaccess entsprechend zu ergänzen!

Hinweis: Die obige Beschreibung gilt für einen Apache-Webserver. Verwendet man einen IIS7-Webserver, dann ist statt der "htaccess.txt" die "web.config.txt" in "web.config" umzubenennen. Für beide Server-Typen gilt: Das URL-Rewrite-Modul muss natürlich auf dem verwendeten Server installiert sein, damit das überhaupt funktionieren kann.

Mit URL-Rewrite und aktiver .htaccess hat die URL nun folgende Form:

https://example.org/blog

Dateiendung an URL anfügen

Ist diese Option aktiviert ("JA"), dann wird eine zum Dokumententyp passende Dateiendung an die URL angehängt. Das ist typischerweise die Endung ".html". Die URL könnte dann beispielsweise so aussehen: https://example.org/fragen.html

Hinsichtlich SEO bringt dies keinen Vorteil. Ganz im Gegenteil: Es empfiehlt sich, diese Option deaktiviert zu lassen ("Nein")!

Unicode Aliase

Prinzipiell kann man in den URLs einer Joomla Webseite auch Umlaute und andere Sonderzeichen zu verwenden. Dazu braucht nur die Option "Unicode Aliase" aktiviert zu werden ("Ja")! Eine URL könnte dann z.B. so aussehen: https://example.org/häufige-fragen

Bleibt diese Option deaktiviert ("Nein"), dann schreibt Joomla das "ä" in "ae" um. Die gleiche URL würde dann folgendermaßen aussehen: https://example.org/haeufige-fragen

Gemäß Google werden diese beiden Varianten gleichwertig betrachtet. Bei internationalen, mehrsprachigen Webseiten könnte es aber bei den Verlinkungen unter Umständen zu Probleme kommen. Es empfiehlt sich deshalb, auf die Nutzung der Unicode Aliase zu verzichten!

Webseitenname auch im Seitentitel

Diese Option hat keine Auswirkung auf die URL-Struktur. Dennoch ist sie interessant, weil sie den Webseitennamen dem im Browser angezeigten Seitentitel automatisch hinzufügen kann. Die Ergänzung des Webseitennamens kann sowohl vor als auch nach dem Seitentitel erfolgen. Beispiele:

"example.org - Kontakt"

"Kontakt - example.org"

Hinweis: Es wird der Webseitenname verwendet, der in der Konfiguration unter "Name der Website" eingetragen ist!

Domain mit oder ohne "www"?

Es stellt sich immer wieder die Frage, ob man eine Domain mit www oder ohne www verwenden sollte. Aus SEO-technischer Sicht ist das egal. Beide Varianten werden von Suchmaschinen gleich behandelt. Wichtig ist nur, dass man sich für 1 Variante entscheidet und dann ausschließlich diese Variante verwendet. Dann hat man die bevorzugte Domain.

Wichtig: Man sollte die nicht verwendete Domain immer mittels 301-Weiterleitung zur bevorzugten Domain weiterleiten. Dadurch kann der Suchmaschinen-Bot die Webseite besser indexieren, da er sich nicht zwischen 2 Varianten entscheiden muss. Des Weiteren vermeidet man sogenannten internen "Duplicate Content". Im Kapitel "OnPage Optimierung" erhalten Sie weitere Information zum Thema "Duplicate Content"!

Ladezeit verringern / Pagespeed erhöhen

Die Ladegeschwindigkeit einer Webseite ist ein sehr wichtiges Kriterium für ein optimales Ranking. Man sollte grundsätzlich untersuchen, wie schnell eine Webseite auf einem PC, einem Tablet und einem Smartphone geladen wird. Die Tendenz geht dahin, dass Suchmaschinen vor allem den Pagespeed von mobilen Webseiten als Kriterium nehmen.

Tipp: Um die Ladegeschwindigkeit zu testen, können Tools wie "Google PageSpeed Insights", "Pingdom Tools" und andere verwendet werden!

Es gibt eine Reihe von Möglichkeiten, die Ladegeschwindigkeit zu optimieren:

Einen geeigneten Hoster und Tarif wählen

Ein Hoster sollte moderne, schnelle und sichere Technik einsetzen!

Je nach Tarif werden verschieden viele Kunden auf einem Webserver gehostet. Mehr Kunden bedeuten in der Regel auch mehr Webseiten und damit mehr Zugriffe. Die Performance wird dadurch schlechter.

Erstellt man seine Webseite auf Basis von Joomla, so sollte man sich einen Joomla-tauglichen Hoster suchen. Selbiges gilt natürlich auch für andere CMS-Systeme.

http/2 verwenden

Falls vorhanden, sollte man statt http/1.1 das neuere Netzwerkprotokolle http/2 verwenden. Dies wird in der Regel vom Hoster automatisch aktiviert. Unterstützt ein Browser dieses Protokoll nicht, so lädt er die Webseite automatisch über http/1.1 . Die Abwärtskompatibilität ist also gewährleistet.

Durch die Nutzung der sogenannten Multiplexing-Technik können bei http/2 die Daten parallel über nur 1 Verbindung übertragen werden, während bei http/1.1 für css-, js- und auch Bilddateien mehrere TCP-Verbindungen nötig sind. Des Weiteren übeträgt http/2 die Daten komprimiert. Auf eine Reihe von weiteren Vorteilen soll an dieser Stelle nicht eingegangen werden.

Es bleibt festzuhalten, dass das http/2-Protokoll im Gegensatz zu http/1.1 die Ladegschwindigkeit einer Webseite deutlich erhöht. Mittlerweile unterstützen die meisten Browser dieses Protokoll.

Cache aktivieren

Damit Daten bei einem erneuten Aufruf einer Webseite nicht immer wieder neu geladen werden müssen, gibt es verschiedene Möglichkeiten, diese zu cachen. Ein Cache ist nicht anderes als ein Zwischenspeicher (Puffer-Speicher). Man unterscheidet zwischen verschiedenen Arten von Caches:

- Joomla-Cache: Joomla selbst bietet verschiedene Möglichkeiten, Daten zwischenzuspeichern: Normales Caching, erweitertes Caching und Seiten-Caching. Welche Methode man verwenden sollte, richtet sich nach der jeweiligen Webseite. Beim erneuten Aufruf einer URL lädt Joomla die Daten direkt aus dem Joomla-Cache. Verwendet man den Seiten-Cache, dann werden sogar ganze Seiten gecacht. Somit müssen diese nicht jedes Mal aus der Datenbank neu generiert werden. Bei interaktiven Webseiten (z.B. auch mit Warenkorbfunktion) empfiehlt sich die Verwendung des Seiten-Cache nicht, da sich die Inhalte ändern und sofort angezeigt werden müssen.

- Server-Cache: Ein Server-Cache, wie beispielsweise der OPCache, ermöglicht es, dass PHP-Skripte nicht bei jedem Aufruf neu kompiliert werden müssen. Diese werden in den Speicher geladen und aus diesem immer abgeholt, solange sich sich nicht geändert haben. Dadurch wird die Performance erhöht. Das Cachen kann mittels RAM oder über Dateien realisiert werden.

- Browser-Cache: Im Cache des Browser (PC, lokal) werden Kopien von bereits aus dem Web abgerufenen Ressourcen abgelegt. Das können z.B. css-, js-, Bilddateien und einiges mehr sein. Liegen beim Aufruf einer URL die benötigten Ressourcen bereits im Cache des Browser, dann werden diese direkt aus diesem abgerufen. Dadurch wird die Zeit des Herunterladens aller Bestandteile einer Webseite deutlich verringert.

Über bestimmte Anweisungen lässt sich der Browser-Cache sogar steuern.

Anzahl der http-Requests minimieren

Wenn der Browser eine Anfrage an den Webserver schickt, dann bezeichnet man das als http-Request. Hierbei kommen meist die Methoden "GET" und "POST" zum Einsatz. Abhängig vom Netzwerkprotokoll und verwendeten Browser können meist mehrere Requests parallel bearbeitet werden. Dennoch empfiehlt es sich, die Anzahl der Requests zu minimieren. Das erreicht man beispielsweise dadurch, dass man mehrere css- oder js-Dateien zu 1 Datei zusammenfasst. Dadurch wir nur 1 Anfrage (Request) an den Server gestellt und nicht für jede Datei einzeln. Die Anzahl der Requests ist für Suchmaschinen ein wichtiger Rankingfaktor. Für Joomla lassen sich css- und js-Dateien mithilfe des Tools JCH Optimize zusammenfassen und gleichzeitig auch minimieren, siehe nächster Punkt!

Optimierung von CSS und JS

Eine Webseite muss in der Regel eine Vielzahl von CSS- und JS-Dateien laden, die teilweise auch noch recht groß sein können. Das geht zu Lasten der Performance. Um die Dateien zu minimieren, gibt es verschiedene Möglichkeiten:

- Vermeidung von Inline-Styles

- Kurzschreibweisen verwenden (z.B. #ccc statt #cccccc)

- Kommentare entfernen

- Leerzeichen entfernen

- alles in 1 Zeile schreiben

Die meisten Editoren und auch verschiedene andere Tools bieten dafür eine Funktion (Komprimierung), die das alles automatisch macht. Wie bereits erwähnt, gibt es für Joomla beispielsweise die Erweiterung "JCH Optimize".

Der Name von optimierten Dateien sollte am besten um ".min" ergänzt werden, damit optimierte und nicht-optimierte Dateien leichter zu unterscheiden sind.

Tipp: Eine formatierte und nicht-komprimierte Datei lässt sich wegen der besseren Übersicht deutlich leichter bearbeiten. Erst nach der Bearbeitung sollte man diese optimieren!

Ladezeit der Bilder optimieren

Wer auf seiner Webseite riesige Bilddateien verwendet, der verlängert die Ladezeit seiner Webseite deutlich. Man sollte die Bildgröße auf die Anzeigegröße reduzieren!

Nehmen wir einmal an, man macht ein Foto in der Größe von 3000 x 2000 Pixeln. Auf der Webseite soll es aber in der Größe mit nur 600x400 Pixeln angezeigt werden. Die Webseite benötigt aufgrund der Dateigröße für das große Bild eine deutlich längere Ladezeit als für das kleine Bild. Daher sollte man das Bild mit einem Bildbearbeitungsprogramm oder auch einem Online-Tool vorher auf die ideale Bildgröße skalieren und erst dann in die Webseite einfügen.Wenn auf einer Webseite gleich mehrere nicht optimierte Bilder verwendet werden, dann wird der Seitenaufbau deutlich verlangsamt und der Besucher der Webseite kann unter Umständen nicht scrollen.

Die Dateigröße eines Bildes lässt sich jedoch nicht nur durch die Anzeigegröße beeinflussen, sondern auch durch das Bildformat (png, jpg, usw.) sowie die verwendete Kompression.

Doch welches ist die ideale Bildgröße?

Webseiten werden auf verschiedenen Geräten (PC, Tablet, Smartphone) mit unterschiedlichen Auflösungen dargestellt. Man sollte Bilder auf die maximale Anzeigedarstellung anpassen. Abschließend sollte man unbedingt noch die Qualität der Bilder auf den verschiedenen Geräten überprüfen!

Lazy Load für Bilder verwenden

Auf Bilder kann man auf einer Webseite selten verzichten. Sie nehmen in der Regel aber das größte Datenvolumen einer Webseite ein. Es gibt jedoch eine Möglichkeit, das Laden von Bildern zu verzögern (Lazy Load).

Wenn beispielsweise am Ende einer Webseite mehrere Bilder eingefügt wurden, die man erst nach dem Scrollen nach unten betrachten kann, so müssen diese Bilder nicht zwingend zuerst geladen werden. "Lazy Load" ("faules Laden") sorgt dafür, dass zunächst nur die Hauptinhalte geladen und angezeigt werden. Das geht relativ schnell. Erst wenn der Benutzer nach unten scrollt und die Bilder in den Sichtbereich kommen, werden sie nachgeladen. Insbesondere für lange Seiten mit vielen Bildern ist "Lazy Load" eine sehr effektive Methode, die Ladezeit einer Webseite zu verringern.

Für Joomla 3 gibt es Plugins, die Bilder nachladen können. Teilweise sind diese auch bereits in Frameworks oder Editoren integriert.

In Joomla 4 wurde "Lazy Load" bereits in den Joomla-Core integriert, so dass keine zusätzlichen Erweiterungen mehr installiert werden müssen.

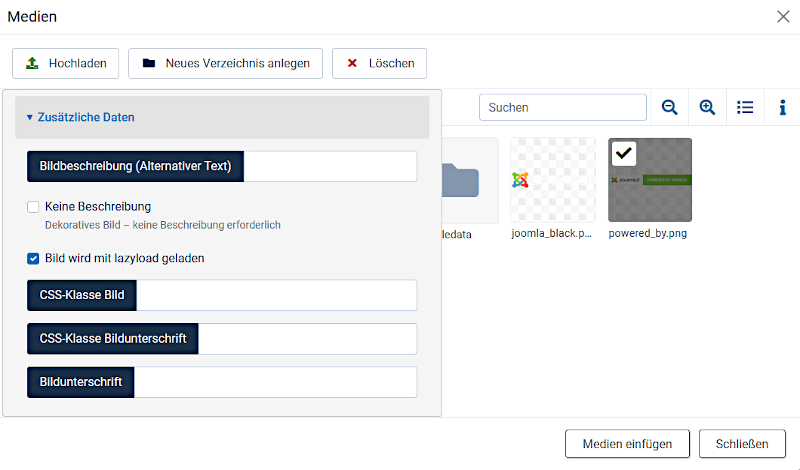

Wenn Sie im TinyMCE ein Bild einfügen, gehen Sie wie folgt vor:

- Klicken Sie den Button "CMS-Inhalt" und wählen dann "Medien"!

- Wählen Sie das Bild aus, welche Sie einfügen möchten!

- Geben Sie an, ob das Bild mit lazyload geladen werden soll oder nicht! (Haken)

- Klicken Sie abschließend auf "Medien einfügen"!

Nun wird dem Bild automatisch der Parameter loading=lazy" beigefügt.

Möchten Sie das Laden des Bildes über "Lazy Load" wieder rückgängig machen, dann entfernen Sie im Quellcode einfach das loading="lazy" ! Soll ein bereits eingefügtes Bild ohne Lazy Load nachträglich verzögert geladen werden, so ergänzen Sie im <img> einfach den Parameter oder fügen Sie das Bild erneut ein!

Hinweis: Über "Bild einfügen/bearbeiten" lässt sich "Lazy Load" nicht aktivieren!

Wichtig: "Lazy Load" hat auch einen Nachteil. Crawler von Suchmaschinen können nachzuladende Inhalte bei der Indexierung nicht erfassen. Deshalb empfiehlt es sich, "Lazy Load" lediglich zur Reduzierung der Datenübertragung für weniger relevante Bilder zu verwenden!

Core Web Vitals analysieren

Google untersucht als wichtiges Rankingkriterium die sogenannten "Core Web Vitals"! Deshalb sollte man sich damit einmal genauer beschäftigen. Da dieses Thema jedoch sehr umfangreich ist, wurde diesem ein eigener Abschnitt gewidmet:

Eventuell CDN nutzen

CDN steht für "Content Delivery Network" und ist ein Netzwerk von Servern (Proxy- oder Edge-Server) an verschiedenen Standorten weltweit. Nutzt man CDN für seine Webseite, dann werden die Daten automatisch von dem Server geladen, der dem Besucher einer Webseite am nächsten ist. Dadurch können Inhalte deutlich schneller zum Webseiten-Besucher übertragen werden. Des Weiteren verbessert die Nutzung von CDN auch die Sicherheit. Darauf soll an dieser Stelle aber nicht eingegangen werden. Ob CDN für eine Webseite sinnvoll ist, das hängt von der Webseite selber ab.

Die Implementierung von CDN ist heutzutage deutlich kostengünstiger als noch vor 20 Jahren. Es gibt eine Reihe von Anbietern: KeyCDN, Cloudflare, Amazon CloudFront, Azure (Microsoft) und einige mehr.

Die Verwendung von CDN ist allerdings nicht ganz trivial und setzt einige Kentnisse voraus. Die CDN-Anbieter haben teilweise aber auch recht gute Dokumentationen.

Sauberen Code verwenden

Ein valider Quellcode ist wichtig für das Ranking einer Webseite. Denn kein User nutzt gerne eine Webseite, auf der Fehler vorhanden sind. Und keine Suchmaschine empfiehlt fehlerbehaftete Webseiten. Des Weiteren sollte eine Webseite auch nicht unbedingt mehr Code als nötig enthalten, da dies zu einem längeren Ladevorgang der Webseite führt.

XML-Sitemap erstellen

Eine Webseite besteht meist aus einer Vielzahl von Seiten (URLs). Im Idealfall sind diese untereinander auch gut verlinkt. Dadurch können die Bots der Suchmaschinen diese Seiten relativ einfach finden und indexieren. Dennoch empfehlen die Suchmaschinen-Betreiber die Erstellung einer sogenannten XML-Sitemap.

Eine XML-Sitemap beinhaltet alle Seiten (URLs) einer Webseite. Dadurch können auch weniger gut oder gar nicht verlinkte Seiten (URLs) gecrawlt und indexiert werden. Die XML-Sitemap liegt typischerweise im Root-Verzeichnis einer Webseite und wird von den Suchmaschinen regelmäßig gelesen. Man kann diese auch zusätzlich z.B. in der "Google Search Console" (GSC) einreichen. Zusätzlich lässt sich der Link zur Sitemap auch in der robots.txt eintragen.

Eine XML-Sitemap ist eine Textdatei im Format XML (Extensible Markup Language).

Nicht zu verwechseln ist die XML-Sitemap mit der HTML-Sitemap, welche dem Besucher der Webseite die Seiten (URLs) direkt im Browser anzeigt und somit die Nutzerführung verbessern kann! Die HTML-Sitemap findet in der heutigen Zeit allerdings so gut wie keine Verwendung mehr.

Für Bilder, Videos und auch Neuigkeiten (News) können mittlerweile eigene XML-Sitemaps generiert werden.

Es ist wichtig, die Struktur einer XML-Sitemap zu beachten, damit die URLs von den Webcrawlern auch korrekt ausgelesen werden können. Reicht man diese z.B. in der GSC ein, dann findet eine automatische Überprüfung der Sitemap statt.

Eine typische XML-Sitemap hat folgenden Aufbau:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<url>

<loc>https://www.example.org/</loc>

<lastmod>2021-12-01T18:35:48+00:00</lastmod>

</url>

<url>

.....

</url>

</urlset>

Innerhalb <url>...</url> werden die einzelnen Elemente für die jeweilige URL angegeben. Hierbei bedeuten die Elemente folgendes:

- <loc> : URL

- <lastmod> : Datum und Uhrzeit der letzten Änderung der URL

- <changefreq> : Ungefähre Änderungsfrequenz der URL, z.B. always, hourly, daily, weekly, monthly, yearly, never

- <priority> : Wichtigkeit einer URL innerhalb der Domain (0,0 - 1,0). Standard: 0,5 . Priority hat für Google allerdings keine Relevanz.

Hinweis: Möchte man eine XML-Sitemap für eine mehrsprachige Webseite erstellen, dann kommen weitere Elemente hinzu, da man für jede URL auch alle korrespondierenden URLs der anderen Sprachen angeben muss. Aufgrund der Komplexität kann das hier nicht näher ausgeführt werden.

Tipp: Es gibt XML-Sitemap-Generatoren, die eine Webseite durchsuchen und die URLs automatisch in korrekter Form in die Datei schreiben. Diese Generatoren lassen sich teils sehr genau einstellen, um auch URLs zu finden, die nicht gut verlinkt sind. Insbesondere bei großen, komplexen oder mehrsprachigen Webseiten sind die XML-Sitemap-Generatoren sehr zu empfehlen!

robots.txt anpassen

Mit Hilfe der Datei "robots.txt" kann man einer Suchmaschine grundlegend mitteilen, welche Seiten sie nicht crawlen soll (disallow). Davon können Ausnahmen gemacht werden (allow). Es lassen sich für die verschiedenen Suchmaschinen auch unterschiedliche Angaben machen. Die robots.txt ist im Prinzip eine Textdatei mit einem bestimmten Aufbau. Sie liegt im Rootverzeichnis einer Webseite. Bei Verwendung von Joomla muss diese in der Regel nur noch geringfügig angepasst werden. Ist die robots.txt nicht optimal an eine Webseite angepasst, so kann sie die Crawler im schlimmsten Fall sogar davon abhalten, eine Seite (URL) zu crawlen und in den Index ihrer Suchmaschine aufzunehmen. Man sollte die robots.txt also in jedem Fall genauestens überprüfen und bei Bedarf korrigieren!

Hinweis: Die Bots der Suchmaschinen müssen sich nicht zwingend an die Angaben in der robots.txt halten. Die seriösen Suchmaschinen wie beispielsweise Google, Bing und viele andere machen das allerdings.

Beispiel anhand der robots.txt von Joomla:

User-agent: *

Disallow: /administrator/

Disallow: /bin/

Disallow: /cache/

Disallow: /cli/

Disallow: /components/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /layouts/

Disallow: /libraries/

Disallow: /logs/

Disallow: /modules/

Disallow: /plugins/

Disallow: /tmp/

Aufgrund der Angabe User-agent: * werden alle Suchmaschinen angesprochen.

Webseite vor bestimmten Zugriffen schützen

Es kann vorkommen, dass durch eine hohe Anzahl von Zugriffen auch ein hohes "Hintergrundrauschen" generiert wird. Das ist insbesondere dann unvorteilhaft, wenn viele Zugriffe auf die Webseite dieser überhaupt keinen Nutzen bringen. Ein hohes "Hintergrundrauschen" kann nämlich zur Folge haben, dass sich die Performance verschlechtert, was wiederum zu einem schlechteren Ranking führen könnte. Sollte das der Fall sein, dann gibt es mehrere Möglichkeiten, dies zu verhindern:

Sehr effektiv ist es, wenn man die betroffenen IP-Adressen oder User-Agents über entsprechende Einträge in die .htaccess sperrt. Dann werden diese Zugriffe direkt vom Server blockiert, noch bevor überhaupt auf das verwendete CMS-System wie z.B. Joomla und seine Datenbank zugegriffen wird. Es sollte beachtet werden, dass sich die User-Agents jederzeit ändern können. Eine regelmäßige Überprüfung ist also empfehlenswert. Hierzu sind die entsprechenden log-Dateien auszuwerten. Das kann sehr zeitintensiv sein.

Tipp: Es kann sinnvoll sein, bzgl. der User-Agents zunächst einen entsprechenden Eintrag in die robots.txt zu schreiben! Schließlich halten sich die meisten Bots bereits an diese Anweisung. Nur in hartnäckigen Fällen sollte man die Sperre über die .htaccess realisieren. Auf jeden Fall sollte man dann für die robots.txt eine Ausnahme in der .htaccess machen, damit der Zugriff auf die robots.txt in jedem Fall möglich ist.

Seite muss crawlbar und indexierbar sein

Damit ein Crawler bzw. Bot (Suchmaschine) eine Webseite auslesen und analysieren kann, muss dieser auf alle Inhalte (Links, Bilder, Skripte, Cache...) einer Webseite zugreifen können. Das ist nämlich die Voraussetzung, damit eine Seite auch indexiert werden kann. Erst dann ist diese im Google-Index aufgenommen und kann in den Ergebnissen der Suchmaschinen (SERPs) angezeigt werden.

Es gibt eine Reihe von Faktoren, die das Crawlen und Indexieren einer Seite (URL) stark beeinflussen können:

- Serverfehler

- Blockierung in robots.txt oder .htaccess

- Probleme mit Weiterleitungen oder 404

- Schlechte Seiten- und URL-Struktur

- Teile einer Webseite wie Skripte, CSS-Dateien usw. werden nicht geladen

- Webseite wurde gehackt oder ist unsicher

- Webseite steht auf einer Blacklist

Es gibt verschiedene Online-Tools, mit denen man seine Webseite auf derartige Probleme hin untersuchen kann! Sinnvoll ist es zudem, sich z.B. in der "Google Search Console" (GSC) anzumelden! Die Webseite wird dann regelmäßig analysiert und Probleme werden automatisch per Email mitgeteilt.